サービス

SEOにおける重複コンテンツとは?原因と対策方法

SEOに携わっている人であれば、「重複コンテンツ」という言葉を聞いたことがある人がほとんどだと思います。

本記事では、重複が発生することが何故いけないのか、重複が発生してしまう具体的な原因や対策方法について解説していきます。

SEOの評価を下げる危険性のある重複コンテンツについての理解を深めて、今後のサイト運営に活かしていってください。

目次

重複コンテンツとは?

重複コンテンツとは大きく2種類に区分され、サイト内部の重複とサイト外部の重複があります。

サイト内部であれば、システム改修によって防げるものも多いですが、サイト外部の場合であれば他社(他者)に依頼を取る必要がある場合も。

それぞれについて詳しく解説します。

サイト内部の重複コンテンツとは

自社サイト内で重複してしまうケースのことを指します。

SEOおたく

SEOおたくシステム的な問題であったり、パラメータを管理してなかった結果発生してしまう場合が多いです。

多くは下記のパターンに当てはまり、その結果としてインデックスが安定しなかったり、被リンクなどの外部評価も分散してしまい、順位が安定しない、ないしは順位が上がらない、ということが起こりえます。

- httpとhttpsとの重複

- www有り無しの重複

- URL末尾の/index.html有り無しの重複

- セパレートURLであれば、PCとSPのsp.example.comとexample.comとのデバイス重複

- 表示するコンテンツは同じでも、URLパラメータ有り無しの重複

- 細かいところでは、URL末尾のトレイリングスラッシュ有り無しの重複

- URLを静的化したが、動的なURLが残っておりURL構造違いの重複

新しくSEOコンサルティングに入るサイトでは、割と多くの確率で何かしらの重複コンテンツが発生しています。

それぞれ簡易的に確認することもできるので、上記のケースなどを参考にしながらぜひ一度自社サイト内で重複が発生していないかを確認してみてください。

サイト外部の重複コンテンツとは

自社サイトと外部のサイトのコンテンツが重複してしまうことを指します。

自社のコンテンツが他社に盗用されてしまっているケースもまれにあるかもしれません。

見つけ方としては本文の一部分をコピーして、Google検索にかけた際に自社記事以外で完全一致でヒットするものがあるかを調べるやり方か、サードパーティーツールを利用して重複度合いをチェックするなどのやり方があります。

コピペチェックツールなどを利用すると「重複率判定」などもできますので、そちらも利用してみると良いでしょう。

他にはコンテンツシンジケーションというものもあります。

具体例としては、ニュースサイトが自社サイトの他にYahoo!ニュースなどにも記事を転載するケースです。

コンテンツシンジケーションはSEOの技術的な話もそうですが、利害関係も絡むため非常に難しい問題ですので、ベストプラクティス通りにはいかない部分になります。

※無料お役立ち資料:「独自性が勝負を決める!新時代のSEO戦略とオリジナルコンテンツ制作の秘訣」をダウンロードする>>こちらから

なぜ重複コンテンツは良くないものとして扱われるのか

そもそもGoogleは何故重複コンテンツを厳しく対処するのでしょうか?

Googleのdeveloperページを引用すると以下の通りです。

検索エンジンのランキング操作やトラフィックの増大を意図して、コンテンツが複数ドメインにまたがって複製されていることもあります。この種の偽装行為は、ユーザーが検索結果で実質的に同じコンテンツを何度も見ることになり、利便性の低下につながります。

重複コンテンツの作成を避ける

Google は、固有の情報を持つページをインデックスに登録して表示するよう努めています。たとえば、記事ごとに「通常」バージョンのサイトと「印刷」バージョンのサイトがあり、どちらも noindex メタタグでブロックされていない場合、Google はどちらか一方を選択して登録します。ごくまれなケースとして、Google でのランキングの操作やユーザーへの偽装を意図した重複コンテンツが表示される可能性が認識された場合も、Google では関係するサイトのインデックス登録とランキングに対して適切な調整を行います。その場合、該当するサイトはランキングが低下するか、Google インデックスから完全に削除されて検索結果に表示されなくなる可能性があります。

重複コンテンツの作成を避ける

端的に言ってしまえば、良質な検索結果の妨げとなるため、そういったサイト/コンテンツはインデックスから削除したり、ランキングを低下するというものです。

ここからは考察も入りますが、WEBマスター側のコンテンツ作成のコストと工数が低下していった結果、コンテンツ(サイト)の量が爆発的に増加し、元々のランキングシグナルでは対応できなくなったため改良したのでは、と思っています。

2007年の全世界公開ウェブサイト数は121,892,000でしたが、2017年には1,766,000,000にも膨れ上がっており、指数関数的に増加しています。

近年であればクラウドソーシングサービスの普及であったり、誰でも無料ですぐにホームページを作成できるようになってきました。

その反面、誰でも手軽にwebサイトやwebページを公開できるようになったものの、クオリティのバラツキがある状態になったり、スパムが横行しました。

これらを取り締まる目的として始まったのがパンダアップデートだと捉えています。

なので今日においては、情報が増えすぎた結果どの情報が信頼性高いの?の目安として、EATのシグナルを導入したり、運営元が信頼できるところなのか、といったところまで重視されるに至っていると思っています。

Googleの使命は「世界中の情報を整理し、世界中の人がアクセスできて使えるようにすること」であり、情報の整理の一環でクオリティコントロールをしている、とも捉えられるかもしれません。

クオリティが低いものにアクセスできたとしてもその情報は使えないかもしれませんし、信頼性が乏しいものかもしれません。

また、被リンクも分散してしまう可能性もあるため、なるべく1つのコンテンツは1つのURLに評価を集約したほうがシンプルだよねと考えていただくのが良いかもしれませんね。

もっと細かい話をすると、大規模サイトにおいてはちょっとの重複でかなりのクローラーリソースを浪費してしまい、その結果として新着コンテンツのインデックス速度が低下し、トラフィックや売上棄損につながる可能性も秘めているため、サイトの規模が大きくなるほどよりセンシティブに扱わなければならないとも思います。

参考:Googleの使命

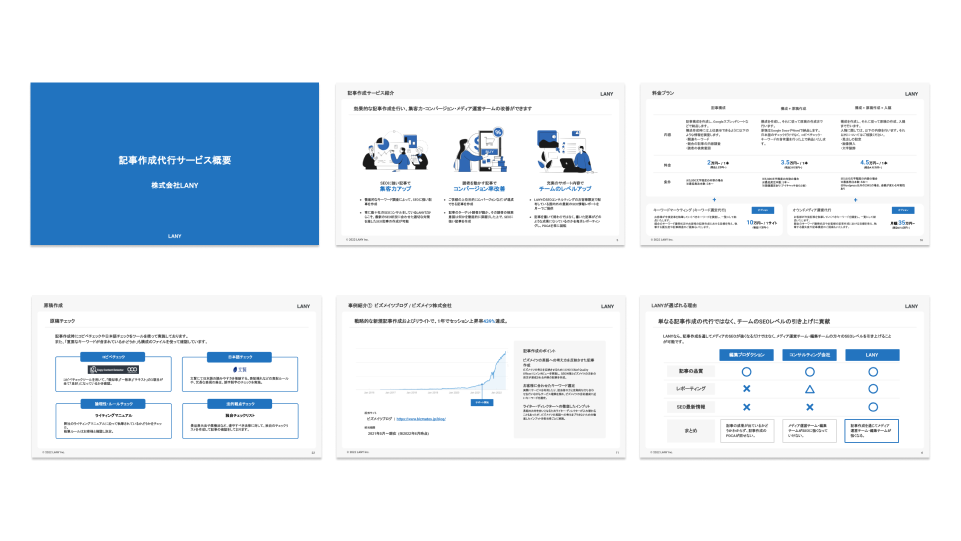

記事作成についてお悩みの方へ

LANYの記事作成代行サービス概要資料

LANYのサービス導入事例

株式会社森永乳業 様(ご利用サービス:記事作成代行)

公開したコラムの分析結果を見ると、Google検索からの流入数が確実に伸びていて順位もつきました!

▶︎記事作成代行事例を見る

重複コンテンツがSEOに与える影響とは

ここまで記載してきた内容を整理すると、重複コンテンツは下記の3点のようにネガティブな影響を与える可能性があります。

- 外部評価が分散する可能性がある

- クローラーのリソースが無駄遣いされ、本来回遊してほしいページが回遊されなくなる、または回遊頻度が低下する可能性がある

- 自サイト内のシステム的な問題などで重複していてもペナルティにはならないが、Google でのランキングの操作やユーザーへの偽装を意図した重複コンテンツが表示される可能性が認識された場合にはインデックスから削除されたり、ランキングが低下するリスクがある

本来のサイトパフォーマンスを十分に発揮できなくなる可能性があるため、できうる限り重複へのケアはしておくことが望ましいでしょう。

サイト内部の重複対策

サイト内部の重複には前述したとおり、下記のようなケースが存在します。

- httpとhttpsとの重複

- www有り無しの重複

- URL末尾の/index.html有り無しの重複

- セパレートURLであれば、PCとSPのsp.example.comとexample.comとのデバイス重複

- 表示するコンテンツは同じでも、URLパラメータ有り無しの重複

- 細かいところでは、URL末尾のトレイリングスラッシュ有り無しの重複

- URLを静的化したが、動的なURLが残っておりURL構造違いの重複

まずやるべきこととしては、統一するための代表URLを決めることです。

決めた後に、そのURLを正として、301リダイレクトでwwwありなしやhttpとhttps、末尾/index.html有り無しの統一を図ります。

ここは結構重要なポイントですが、意外と見落とされているケースもあります。

これも細かい話ですが、名刺をお持ちの方は名刺表記のURLが微妙に変わってしまうケースもあると思うので注意が必要です。

次に、サイト内部に統一前のURLが残存していないかを調べ、すべて統一後のURLに書き換えることです。

内部リンクの書き換えを実行しなくとも重複ケアにはなっていますが、クロールバジェットケアにはならない(古いURLの内部リンクが残っている限り、googlebotは新旧URL双方にアクセスする可能性があり、バジェットが無駄になってしまうケースも考えられます)

パラメータの対処としては大きく2つで、canonicalによるURL正規化とサーチコンソールのURLパラメータ制御ツールを使用することです。

URLパラメータ制御ツールは現在どこまで機能しているのか懐疑的に捉えているため、基本的にはcanonicalをメインとして保険的にセットしておくことをお勧めします。

あわせて読みたい

canonicalタグとは?適切に設定するメリットや書き方、改善事例を紹介

サイトを運営していく中で、どうしても重複コンテンツが発生してしまい悩みを抱えている担当者の方も多いのではないでしょうか?そのまま放置すると、SEO上の悪影響も懸…

セパレートURLの場合、デバイスアノテーションを設定する必要があるため、詳しくは下記を参照ください。

静的URLと動的URLの場合、ここでは旧URLが動的だったとします。

優先度としては①リダイレクト、②canonical、③それでもダメならnoindexまたはrobots.txtでDisallow の順に新旧URLの統一または正規化、または重複ケアを施せると良いでしょう。

サイト外部の重複対策

上述した検索方法またはサードパーティーツールで、自社のコンテンツが盗用されていると判明した際には該当サイト運営者に連絡しましょう。

ただし、連絡したからと言って削除されるとは限らないので、削除されなかった場合にはgoogleが用意しているコンテンツ除外の申し立てフォームがありますので、下記から内容を良く確認したうえで送信いただけると良いかと思います。

コンテンツシンジケーションで悩んでいる場合には、コンテンツの提供先に下記のどれかをお願いするところから始めてみてください。

- 転載したページをnoindexにしてもらう

- 転載したページから転載元のオリジナルページにCanonicalを向けてもらう

- 転載したページ内に転載元のオリジナルページのURLを設置してもらう

ただし、SEOの利害関係上なかなか上記のような対応をしてくれるサイトも少ないため、その場合には「提供先よりも早くインデックスさせること」を意識しましょう。

そのために、サイトの階層の浅いページ(TOPページなど)に新着ページへの導線を設置したり、sitemap.xmlを機能させるように工夫したり、Googleサーチコンソールにてインデックス登録リクエストを送るなど、できることから始めましょう。

それでもなかなかインデックスが早まらない場合には、不要なコンテンツを削除することでクロールバジェットを節約するなどの別対応をしてあげると良いです。

記事作成についてお悩みの方へ

LANYの記事作成代行サービス

- サービス・料金プランの詳細

- 提供内容のアウトプットイメージ

- 記事作成の事例

LANYのサービス導入事例

株式会社森永乳業 様(ご利用サービス:記事作成代行)

公開したコラムの分析結果を見ると、Google検索からの流入数が確実に伸びていて順位もつきました!

▶︎記事作成代行事例を見る

まとめ

本記事ではSEOにおける重複について解説しました。

サイト運営を行っていると度々ぶつかる問題かもしれませんが、要因の特定と打ち手をしっかり打っていくことでケアできるものがほとんどだと思います。

重複コンテンツを無自覚で生成してしまい、サイトの評価を水に流してしまうのは非常にもったいないので、きちんとサイト内をチェックして、必要に応じて対応してあげてください。

LANYは、重複コンテンツの特定などを含むテクニカルなSEOの分析を得意としております。

ぜひサイト運営やSEOにお困りのことがある方は、お気軽にLANYのお問い合わせフォームよりご連絡いただけますと幸いです。

ebook

【無料お役立ち資料】

独自性が勝負を決める!

新時代のSEO戦略とオリジナルコンテンツ制作の秘訣

- オリジナリティが重要になった背景

- SEOにおける「オリジナリティ」とは

- 記事でオリジナリティを出していく方法

- オリジナリティのある記事の事例